学hadoop需要掌握什么基础

hadoop是做什么的?

Hadoop是一个开源的大数据框架,是一个分布式计算的解决方案。Hadoop的两个核心解决了数据存储问题(HDFS分布式文件系统)和分布式计算问题(MapRe-duce)。

举例1:用户想要获取某个路径的数据,数据存放在很多的机器上,作为用户不用考虑在哪台机器上,HD-FS自动搞定。

举例2:如果一个100p的文件,希望过滤出含有Hadoop字符串的行。这种场景下,HDFS分布式存储,突破了服务器硬盘大小的限制,解决了单台机器无法存储大文件的问题,同时MapReduce分布式计算可以将大数据量的作业先分片计算,最后汇总输出。

学hadoop需要什么基础?难学吗?

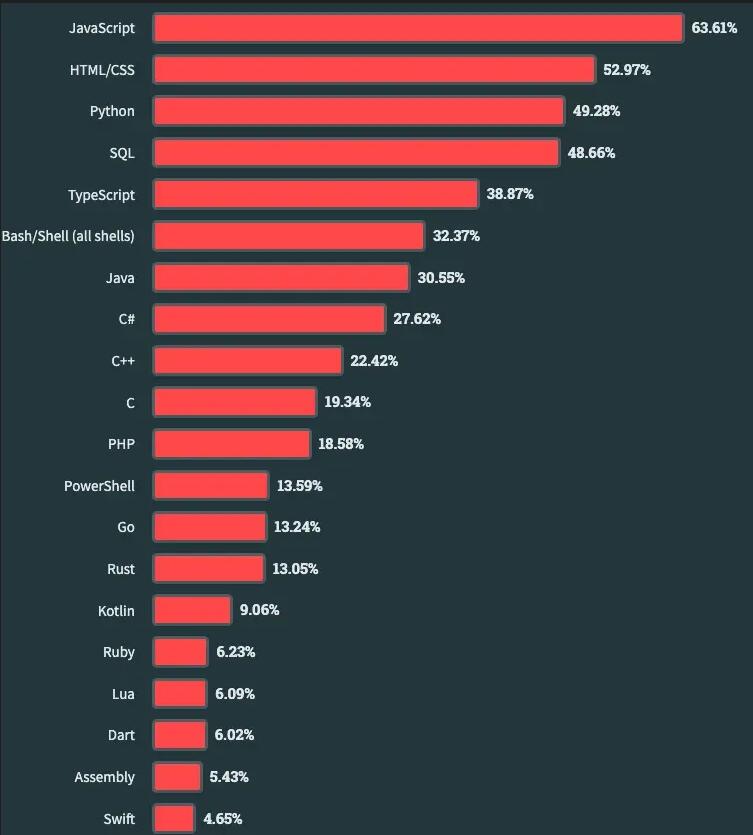

学hadoop之前需要会虚拟机搭建,Linux操作系统设置、Python或者Java语言等,详细如下:

一、Linux:

1、需要能够熟练操作linux常用命令以及网络配置;

2、熟悉用户以及权限管理操作;

3、需要熟悉软件包以及系统命令管理;

4、还需要学习一下shell编程。

二、Java:

1、需要具备一定的javase基础知识;

2、如果懂java web及各种框架知识那就更好了。

三、虚拟机:

1、需要掌握虚拟机;

2、需要安装linux操作系统;

3、需要配置虚拟机网络。

除了上述这几个方面,我们还需要了解hadoop的单机模式、伪分布模式和分布式模式的搭建方式。了解MapReduce分布式计算框架、Yarn集群资源管理和调度平台、hdfs分布式文件系统、hive数据仓库、HBase实时分布式数据库、Flume日志收集工具、sqoop数据库ETL工具、zookeeper分布式协作服务、Mahout数据挖掘库等。

尊重原创文章, 禁止转载,违者必究!本文地址:https://www.ixywy.com/dsjpx/470.html